Los expertos piden que se detenga el desarrollo de la inteligencia artificial. ¿Qué les impulsa a ello?

La inteligencia artificial está experimentando un enorme auge últimamente. Todo el mundo está tan entusiasmado con esta tecnología que no se da cuenta de los riesgos que podría entrañar en el futuro. Actualmente, los expertos en IA están dando la voz de alarma, advirtiendo de que las empresas deberían empezar a abordar los riesgos antes de que sea demasiado tarde.

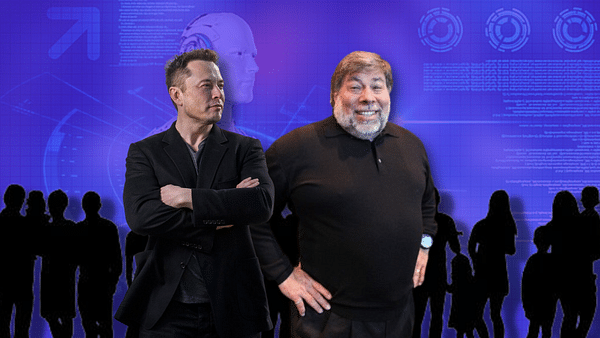

En una reciente carta abierta titulada "Pause Giant AI Experiments: An Open Letter", expertos en inteligencia artificial (IA) piden a las empresas que trabajan en este campo que detengan temporalmente el desarrollo de sistemas de IA generativa. La carta, firmada por más de 1.000 personas, entre ellas Elon Musk, Steve Wozniak, Evan Sharp, Craig Peters y Yoshua Bengio, pone de manifiesto la incertidumbre sobre el posible impacto futuro de los resultados de estos desarrollos.

En la carta, los expertos sugieren una pausa de seis meses para desarrollar políticas y procedimientos reguladores que permitan avanzar con seguridad en la tecnología de la IA. La pausa sólo debería aplicarse al entrenamiento de sistemas de IA más potentes que GPT-4, el modelo de IA generativa desarrollado por OpenAI. Si no se atiende el llamamiento de los expertos, la carta sugiere que los gobiernos impongan una moratoria.

Entre las empresas que invierten en el desarrollo de IA generativa y tecnologías afines figuran gigantes como Microsoft $MSFT, Alphabet $GOOGL, Alibaba $BABA y Baidu $BIDU. La carta de los expertos pide protocolos de seguridad y garantías de impacto positivo y gestión de riesgos. El resultado de la carta podría dar lugar a que las empresas se detengan y formulen nuevas políticas o, al menos, reflexionen sobre los impactos potenciales y tomen las medidas necesarias.

GPT-4 como desencadenante de posibles problemas

El GPT-4, de reciente introducción, ha impresionado a los usuarios por su capacidad para conversar, redactar canciones y resumir documentos largos. La reacción a este modelo ha llevado a competidores como Alphabet Inc a acelerar el desarrollo de grandes modelos lingüísticos similares. Sin embargo, los expertos en IA piden que se frene el desarrollo hasta que comprendamos mejor las implicaciones y los daños potenciales para la sociedad.

El Future of Life Institute, una organización sin ánimo de lucro financiada principalmente por la Musk Foundation, el grupo londinense Founders Pledge y la Silicon Valley Community Foundation, que publicó una carta abierta, opina que los potentes sistemas de IA sólo deberían desarrollarse cuando estemos seguros de que sus efectos serán positivos y sus riesgos controlables. La organización también reclama un organismo regulador que garantice que el desarrollo de la IA sirve al interés público.

Elon Musk, cofundador de OpenAI y uno de los expertos firmantes de la carta, es conocido por sus advertencias sobre los riesgos potenciales asociados al desarrollo de la IA. Afirma que es esencial establecer protocolos de seguridad compartidos elaborados por expertos independientes, e insta a los desarrolladores a colaborar con los responsables políticos en materia de gobernanza.

El director ejecutivo de OpenAI, Sam Altman, y los consejeros delegados de Alphabet y Microsoft, Sundar Pichai y Satya Nadella, no se encuentran entre los firmantes de la carta abierta. No obstante, la carta representa un paso importante para abrir un debate sobre el futuro de la IA y los riesgos potenciales que plantea.

Posibles implicaciones de la carta

La carta puede tener varias consecuencias. Una de ellas es que las empresas e instituciones de investigación implicadas en el desarrollo de la IA podrían detener temporalmente sus actividades y replantearse sus prácticas. Este escenario permitiría a expertos y reguladores echar un vistazo a los avances hasta la fecha y tomar las medidas necesarias para garantizar la seguridad y la sostenibilidad en el campo de la IA.

Alternativamente, la carta podría conducir a una mayor concienciación sobre los riesgos potenciales asociados al desarrollo de la IA y la necesidad de establecer protocolos de seguridad y procedimientos reguladores. Esto permitiría a las empresas centrarse más en la creación de sistemas de IA más seguros y éticos que tengan un impacto positivo en la sociedad.

Por último, la carta podría inspirar a gobiernos y organizaciones internacionales a considerar la introducción de medidas reguladoras y moratorias para el desarrollo de la IA. De este modo se garantizaría que el desarrollo de la IA se lleva a cabo de acuerdo con los mejores intereses de la sociedad y se gestiona para minimizar los posibles impactos negativos.

Independientemente del resultado de la carta abierta, está claro que el debate sobre la seguridad y la ética del desarrollo de la IA es cada vez más urgente. A medida que sistemas de IA como la GPT-4 se hacen cada vez más omnipresentes en la vida cotidiana, es necesario centrarse en cómo pueden utilizarse estas tecnologías para el bien de la sociedad sin comprometer la privacidad, la seguridad o los intereses de las personas.

Un ejemplo que muestra cómo los sistemas de IA pueden utilizarse para el bien público es el uso de la GPT-4 para resolver problemas medioambientales, sanitarios o económicos. Por otro lado, es importante tener en cuenta posibles riesgos, como el uso indebido de la tecnología para difundir información errónea, manipular la opinión pública o aumentar la desigualdad en el acceso a la tecnología.

La carta abierta "Pausa a los experimentos gigantes de IA" es una llamada a la reflexión sobre el camino que tomará el desarrollo de la IA. Sigue siendo una incógnita si se podrá alcanzar un consenso entre expertos, empresas y gobiernos. Sin embargo, es importante que los científicos, los líderes de la industria y los responsables políticos se centren en trabajar juntos para encontrar formas de asegurar y regular el desarrollo de la IA que redunden en beneficio de la humanidad.

ADVERTENCIA: No soy asesor financiero, y este material no sirve como recomendación financiera o de inversión. El contenido de este material es puramente informativo.